Ollama 模型仓库+OB插件Copilot构建本地的大语言模型

利用 Ollama 开源模型仓库和 Obsidian 笔记软件搭建本地的大型语言模型,即大预言模型。这种方法的优势在于保护个人隐私,并能够结合个人知识库来创建个性化的模型。

Ollama 模型仓库

Ollama 是一个提供多种大型语言模型的开源仓库,用户可以通过简单的命令行操作来下载和运行这些模型。文章列出了 Ollama 支持的模型及其参数、大小和下载命令,包括但不限于 Llama 3、Mistral、Dolphin Phi 等。

安装与配置 Ollama

- 安装:到官网下载Ollama 的 Windows 版,然后一键的傻瓜式安装。

- 查询模型:通过

ollama list命令可以查询已安装的模型。 - 运行模型:使用

ollama serve命令在 Windows 上运行模型,支持默认开机启动。 - 模型安装:比如安装 llama3,只需在 cmd 中运行

ollama run llama3,便可安装并运行该模型(其他模型安装参考其他官网)。

Obsidian 插件配置

- 插件安装:在 Obsidian 中安装名为 copilot 的插件,该插件允许用户直接在 Obsidian 中利用 Ollama 模型。

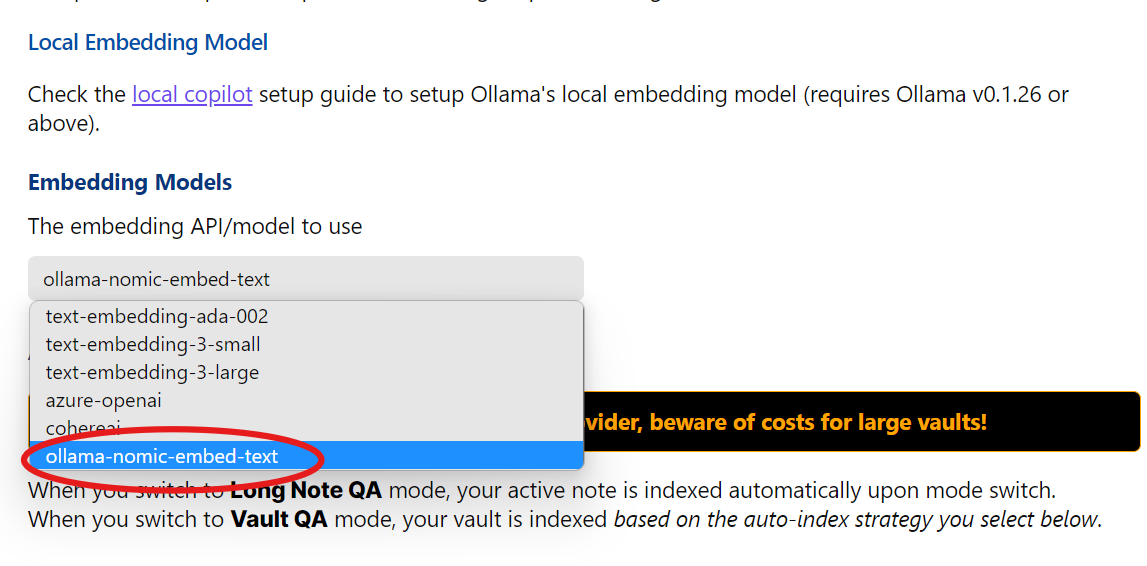

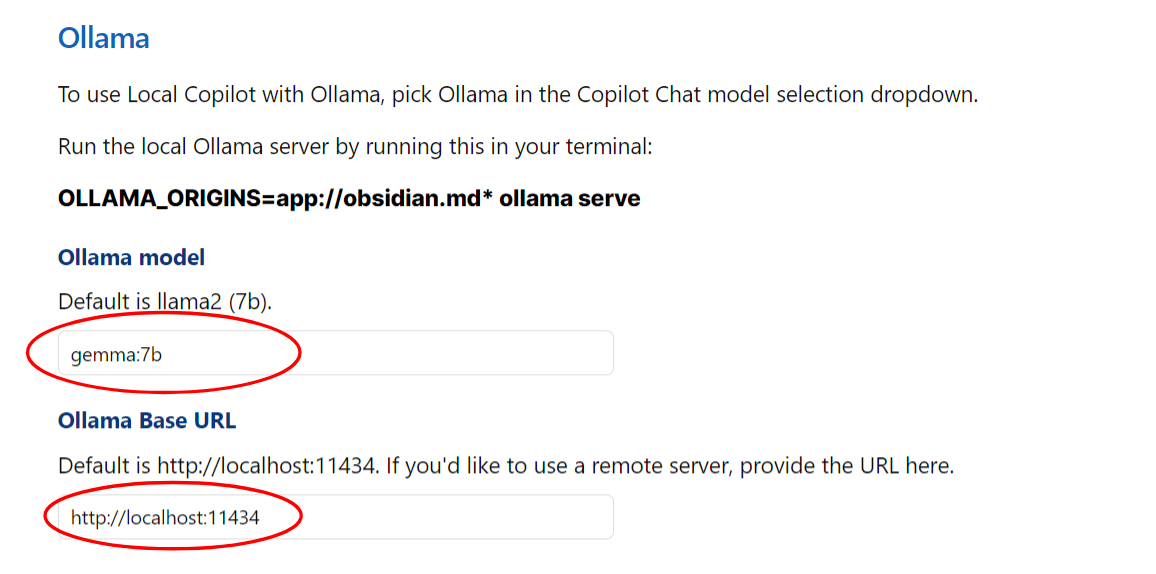

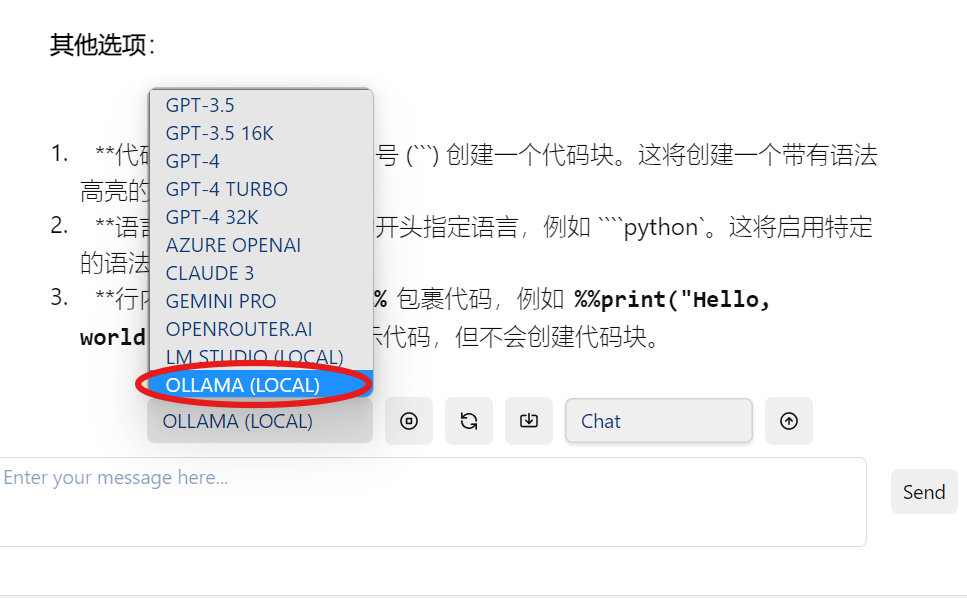

- 插件设置:设置插件时,选择 OLLAMA 作为默认模型,Embedding Model 同样设置为 ollama。Ollama Model 的选择取决于用户下载的模型,如果需要快速响应,推荐使用 qwen 1.8 b 模型。

- 本地地址:Ollama Base URL 设置为

http://localhost:11434

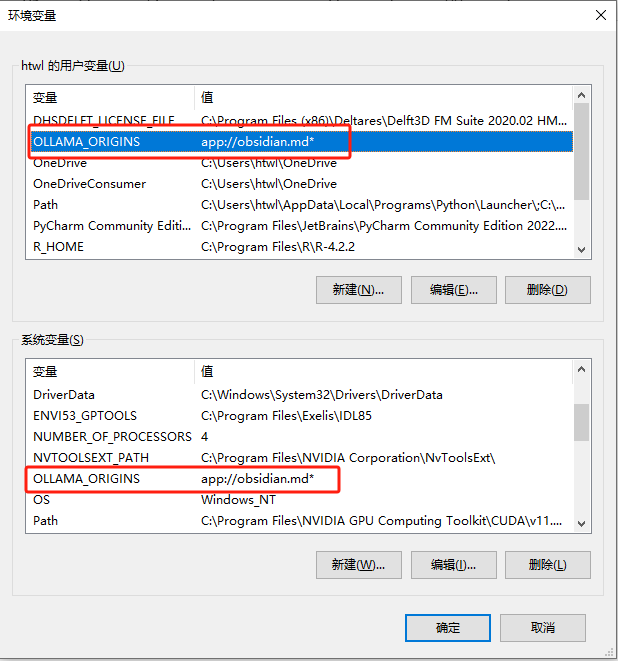

环境变量设置

文章指导用户如何在Obsidian插件中添加环境变量 OLLAMA_ORIGINS=app://obsidian.md*,以确保 Ollama 模型能够正确地与 Obsidian 集成。

使用方法

完成上述设置后,用户可以直接在 Obsidian 中使用 Ollama 模型。文章提到了两种对话方式:

- 直接对话:用户可以直接与模型进行交互。

- 用文件对话:用户可以利用内置的 Prompt 组合与模型进行对话,这种方式会默认以英文回答。

版权声明:

作者:余汉波

链接:https://www.sanrenjz.com/2024/05/17/ollama-%e6%a8%a1%e5%9e%8b%e4%bb%93%e5%ba%93ob%e6%8f%92%e4%bb%b6copilot%e6%9e%84%e5%bb%ba%e6%9c%ac%e5%9c%b0%e7%9a%84%e5%a4%a7%e8%af%ad%e8%a8%80%e6%a8%a1%e5%9e%8b/

文章版权归作者所有,未经允许请勿转载。

THE END